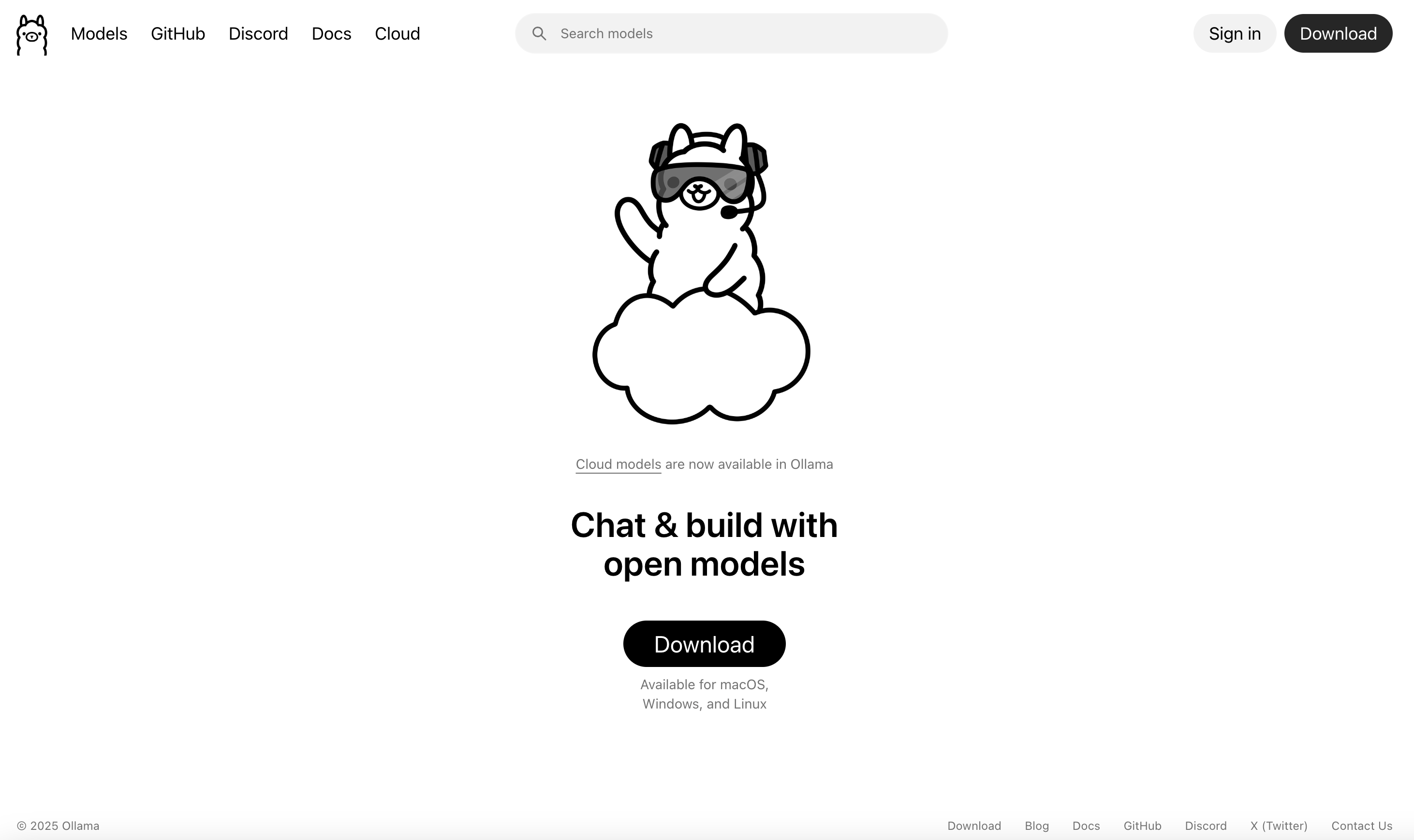

Ollama平台:开源大模型本地化部署与云端协同计算平台

Ollama是一个专注于简化大型语言模型本地部署的开源平台,支持在个人计算机上快速运行各种开源AI模型。该平台通过优化的容器化技术,使开发者能够无需复杂配置即可在本地环境部署和运行Llama、Mistral等主流大语言模型,为AI应用开发和测试提供了便捷的本地化解决方案。最新推出的云模型服务进一步扩展了平台能力,实现了本地与云端计算的灵活协同。

平台功能与服务特色

Ollama核心提供三大功能模块:本地模型管理支持一键式模型下载、版本控制和热更新;跨平台客户端提供macOS、Windows和Linux系统的原生应用,保证各平台一致体验;云端模型服务新增云模型计算能力,弥补本地硬件限制。其技术特色包括:模型量化压缩技术大幅降低资源占用,GPU加速优化提升推理速度,RESTful API接口便于集成到现有应用。平台模型库持续更新,涵盖从70亿到700亿参数的各种规模模型,满足不同计算需求。

应用场景与实用价值

该平台特别适合多类开发场景:AI研究者可本地调试和微调模型,保护研究数据隐私;应用开发者能快速原型验证,减少API调用成本;企业用户可在内网环境部署私有模型,确保数据安全;教育机构可构建低成本的AI教学环境。平台在数据敏感型场景、网络受限环境、长期成本控制需求方面展现突出价值,为中小团队提供了企业级AI能力。

使用流程与操作方法

使用流程极其简化:用户下载对应系统客户端后,通过命令行界面即可管理模型。基础命令如ollama run llama2可快速启动模型服务,ollama pull codellama下载新模型。聊天界面提供交互式对话体验,API接口支持程序化调用。云模型服务可通过账户认证无缝切换,根据任务需求动态分配计算资源。所有操作无需深度学习背景,降低了技术使用门槛。

技术优势与生态建设

平台采用轻量级容器架构,实现模型与依赖环境的隔离封装。智能缓存机制减少重复下载,带宽优化传输加速模型分发。活跃的开源社区贡献大量自定义模型和优化工具,生态持续丰富。与主流开源模型的深度适配确保性能最优,定期更新保持技术前沿性。

总结Ollama通过简化本地模型部署流程,打破了大规模AI应用的技术壁垒,使更多开发者能够接触和利用先进AI技术。其本地+云的混合架构,在保证数据安全的同时提供弹性计算能力,是个人开发者和中小团队体验、学习、应用大模型技术的理想桥梁。随着边缘计算和隐私计算需求增长,该类平台的价值将进一步提升。

数据统计

相关导航

百川大模型

扣子空间

LiblibAI

通义千问

盘古大模型

天工AI智能体

讯飞星火